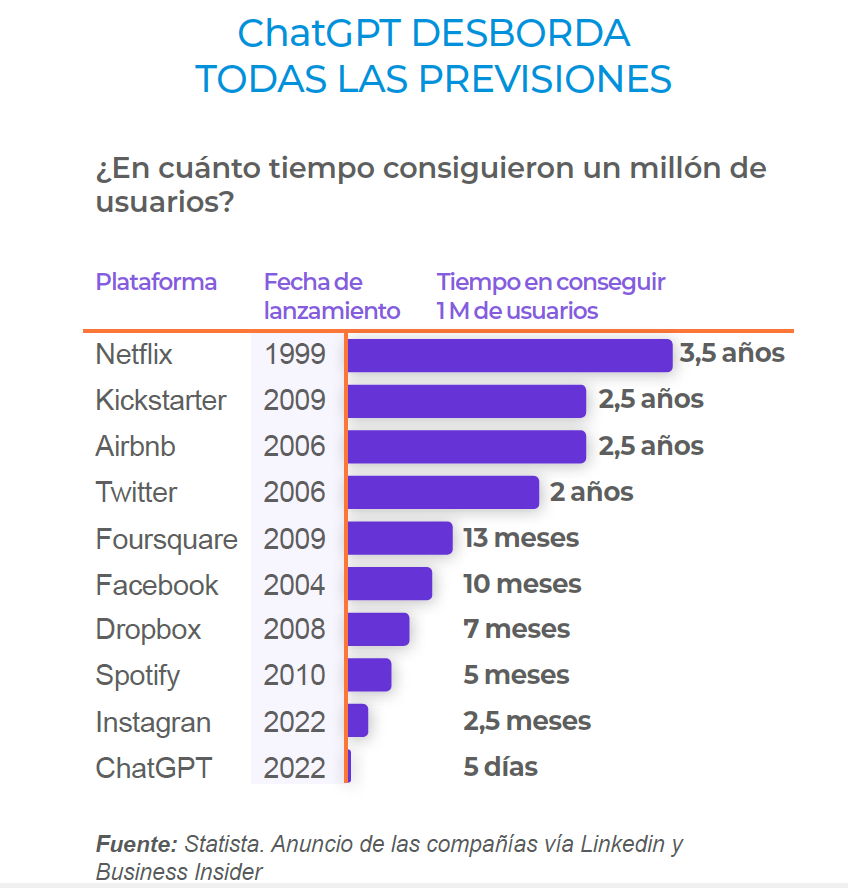

Kai-Fu Lee, inversor y empresario taiwanés, tan popular en China como lo es Elon Musk en Occidente, definió en 2020 el invierno de la Inteligencia Artificial (IA) como el momento en que “la decepcionante falta de resultados prácticos conducía a importantes recortes de financiación”. Desde que en 1950 Alan Turing publicase su artículo Maquinaria computacional e Inteligencia, oficialmente el pistoletazo de salida de la IA, podríamos decir que no habíamos vivido nunca antes un verano tan cálido en este campo como el actual. Y es que ChatGPT, la inteligencia artificial generativa desarrollada por OpenaAI lo ha puesto todo patas arriba. En tan sólo dos meses ha conseguido superar los 100 millones de usuarios en todo el mundo. A Twitter le costó 5 años alcanzar esa cifra, a Instagram dos años y medio y a la popular plataforma de video Tik Tok 9 meses, récord absoluto hasta la irrupción de ChatGPT, que en tan sólo 5 días desde su aparición ya sobrepasaba el millón de usuarios.

A grandes rasgos ChatGPT no es muy diferente a otros Chatbots que conviven con nosotros desde hace tiempo en múltiples servicios de atención al cliente en línea. Es decir, sigue tratándose de un sistema de Inteligencia Artificial capaz de responder preguntas con respuestas elaboradas y convincentes. Sin embargo GPT-3, modelo de lenguaje que utiliza ChatGPT, ha proporcionado un salto sideral sobre esta premisa sorprendiendo por su facilidad para contextualizar e innovar en las respuestas, siendo incluso indistinguible de un ser humano ya que supera el Test de Turing diseñado para diferenciar la persona de la máquina.

A grandes rasgos ChatGPT no es muy diferente a otros Chatbots que conviven con nosotros desde hace tiempo en múltiples servicios de atención al cliente en línea. Es decir, sigue tratándose de un sistema de Inteligencia Artificial capaz de responder preguntas con respuestas elaboradas y convincentes. Sin embargo GPT-3, modelo de lenguaje que utiliza ChatGPT, ha proporcionado un salto sideral sobre esta premisa sorprendiendo por su facilidad para contextualizar e innovar en las respuestas, siendo incluso indistinguible de un ser humano ya que supera el Test de Turing diseñado para diferenciar la persona de la máquina.

Para conseguir esta naturalidad en el lenguaje, OpenAI ha entrenado un modelo de aprendizaje que utiliza toda la información disponible en Internet hasta finales de 2021, fecha de corte que se utilizó para entrenar el modelo con diferentes bases de datos. En total se calcula que se han utilizado 300.000 millones de palabras disponibles en libros, páginas web, artículos, repositorios de código y otros textos de internet. El proceso de aprendizaje del modelo ha tenido en cuenta respuestas proporcionadas por personas y valoradas por jueces por lo que existe un proceso de refinado previo, que lejos de ser perfecto, proporciona resultados más optimizados que los obtenidos con las búsquedas realizadas en buscadores tradicionales. Todo ello con la agilidad que le proporciona al sistema tener toda esa información almacenada pero sobre todo etiquetada sin la necesidad de tener que acudir a la red para cada una de las consultas realizadas. Podríamos decir por tanto, que se trata de un ejercicio faraónico (que no altruista) de indexación de toda la información disponible en internet.

Pero como siempre, no todo es perfecto. Desde un punto de vista de control, es complicado rastrear cada paso del proceso seguido por la máquina ya que la naturaleza autónoma de ChatGPT dificulta la identificación de los errores y el seguimiento del origen del problema.

En relación a los riesgos de seguridad, el código que genera la propia ChatGPT puede ser especialmente vulnerable. Según un estudio publicado por la Universidad de Stanford en diciembre de 2022, los desarrolladores que usan ChatGPT (y/o gitHub Copilot) generan un código de peor calidad y con una cantidad de errores de seguridad significativamente mayor.

Otro frente que plantea la irrupción de ChatGPT es la industrialización de una ingeniería social más sofisticada. Ya se han identificado nuevos usos fraudulentos en el ámbito digital y de la ciberseguridad y es que con la creación de páginas web maliciosas, campañas de phishing altamente dirigidas y estafas como el “deepfake”.

Más allá de las limitaciones técnicas del sistema, nos volvemos a topar con dos viejos conocidos de la inteligencia artificial, el riesgo de sesgo y el riesgo de precisión del sistema (accuracy). En el momento en el que entrenas el modelo con palabras extraídas de internet, automáticamente quedas expuesto a los sesgos, estereotipos y opiniones. Del mismo modo, estos modelos pueden beber de fuentes que pueden ir desde un artículo de opinión a un foro de internet con alta exposición a la desinformación. En este sentido OpenAI ha intentado definir nuevas barreras de protección respecto a otros Chatbots, controlando los prompts (entradas o preguntas) de los usuarios.

En el momento que detecta una cuestión espinosa no prosigue con la conversación, si bien este mecanismo de protección ha presentado múltiples errores hasta la fecha y es fácilmente manipulable. El hecho de ser una herramienta que trabaja con información offline en cierta manera acota la posible contaminación sistémica de una retroalimentación humana maligna pero está muy lejos de eliminarla totalmente. Paradójicamente cuanto más capacidad de aprendizaje y más humana queremos hacer a la máquina, más probabilidad tendrá de mostrar lo peor del comportamiento humano como los prejuicios y las mentiras y hasta la fecha ningún sistema de IA ha sido inmune a este problema.

Sócrates ironizaba asegurando que el oráculo de Delfos le había nombrado el más sabio entre los hombres gracias precisamente a reconocer su ignorancia. En 2023 pasa exactamente lo contrario. Víctimas de la cultura de la inmediatez y puede que de la arrogancia tecnológica podríamos dar por buenas respuestas pensando erróneamente que un chatbot es una suerte de oráculo como el de Delfos. Nada más lejos de la realidad.

Iniciar sesión

Iniciar sesión